Table of Contents

Spark 介绍

Apache Spark(简称Spark)是一个开源的统一分析引擎,专为大规模数据处理设计。它最初由加利福尼亚大学伯克利分校的AMPLab开发,旨在克服Hadoop MapReduce的局限性。Spark能够进行内存中的数据处理,这使得它在处理迭代算法和交互式数据分析时,比传统的MapReduce要快得多(Amazon Web Services, Inc.) (Apache Spark)。

安装

mind:本文格式带有首字母自动大写属性,如复制粘贴指令,请注意将首字母改为小写。

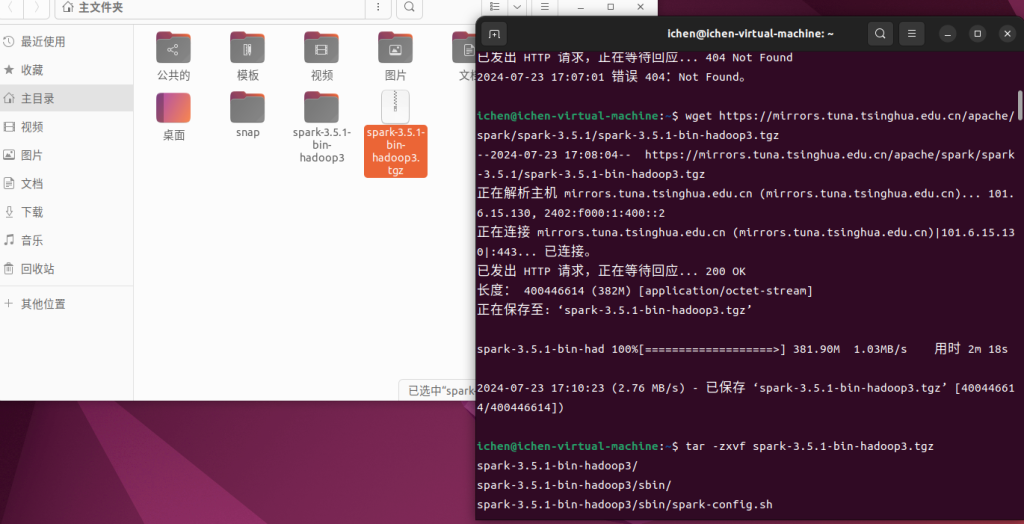

wget https://mirrors.tuna.tsinghua.edu.cn/apache/spark/spark-3.5.1/spark-3.5.1-bin-hadoop3.tgz2. unpack:

tar -zxvf spark-3.3.2-bin-hadoop3.tgz

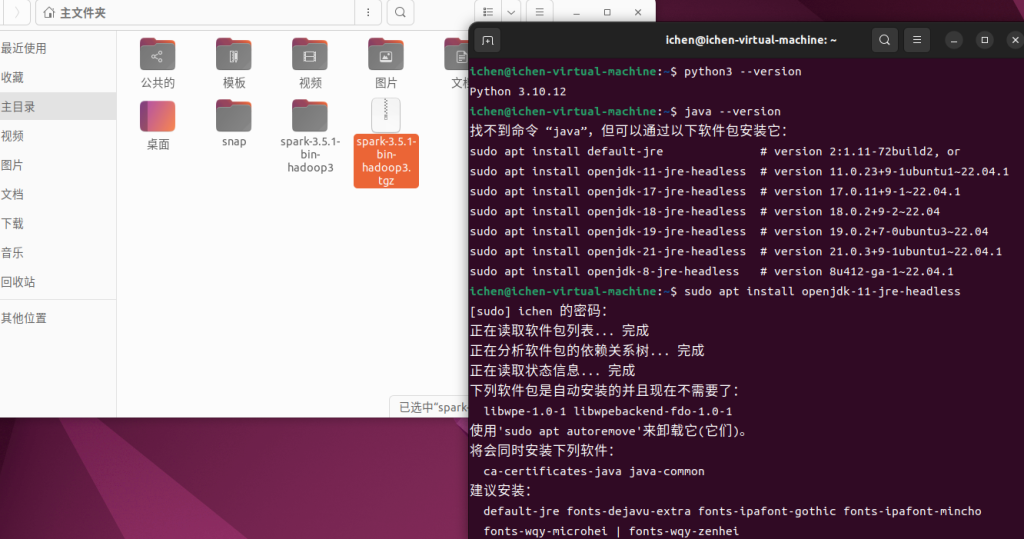

3. 用 “java -version” check 是否有安装java,若无,根据指示安装。

4. 配置环境变量:

vi ~/.bashrc按i进入insert模式,在末尾添加:(如果无法进入insert模式,说明vim未安装,需要通过sudo apt install vim安装vim编辑器)

export SPARK_HOME=~/spark-3.5.1-bin-hadoop3

export PATH=${SPARK_HOME}/bin:$PATHEsc退出insert模式,输入:wq命令保存并退出vim。

5. 使用source ~/.bashrc使.bashrc文件配置生效。

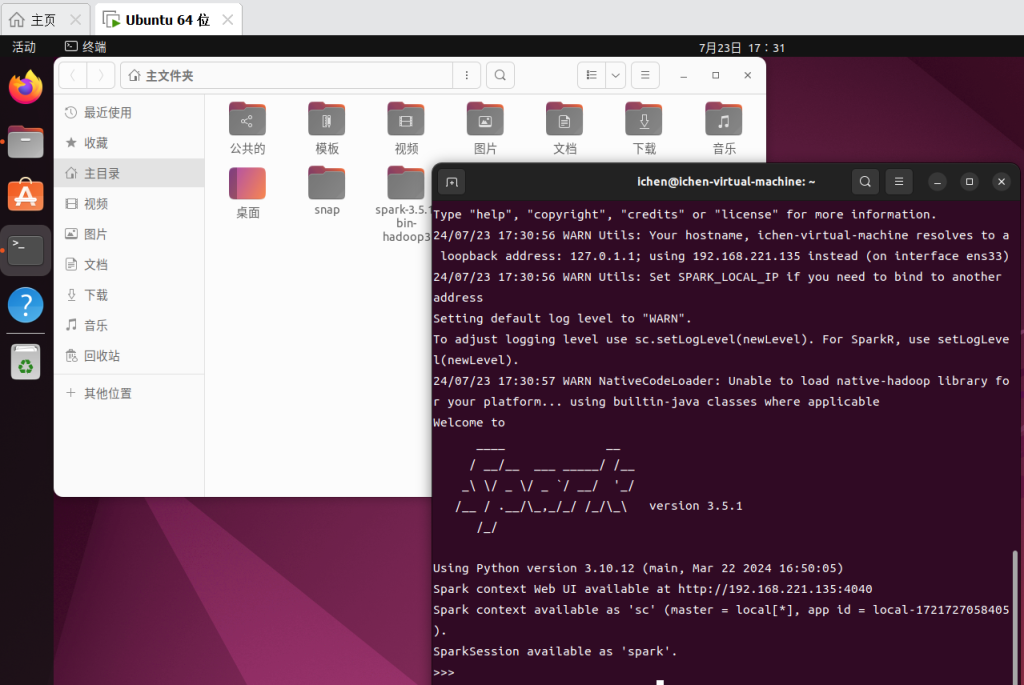

6. pyspark/ctrl+d退出

Jupyter配置

参考了:https://www.cnblogs.com/kingwz/p/18132309

先安装anaconda,需要下载.sh文件。老规矩,先上清华镜像!:https://mirrors.tuna.tsinghua.edu.cn/anaconda/archive/ 不过我用wget命令获取时出现了403错误,通过在windows下载粘贴过去的。

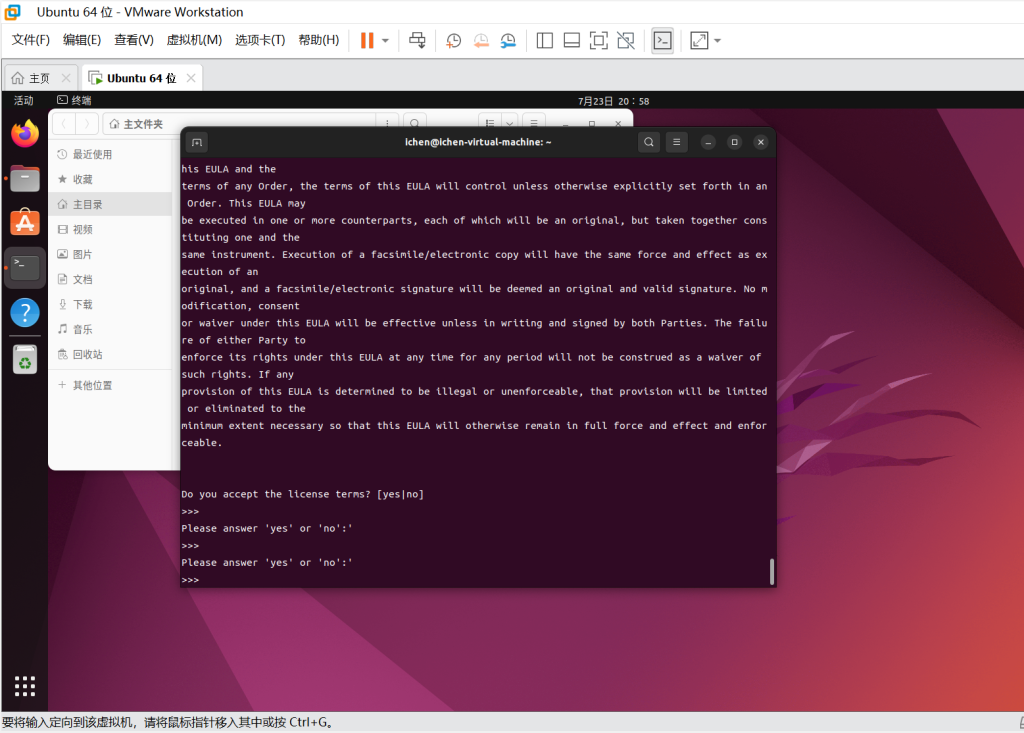

使用bash命令进行安装,一直回车到answer yes or no。

bash Anaconda3-2024.02-1-Linux-x86_64.sh

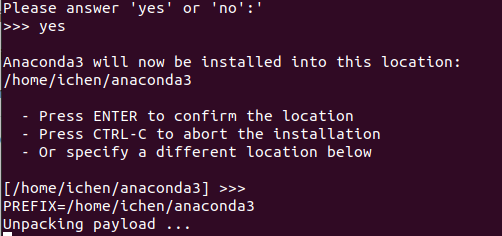

然后会问安装目录:选择默认目录则直接回车,若自定义目录则输入路径。之后再输入一次yes。如果在输入yes之前出现了error应该是磁盘空间不够了,尝试扩容。

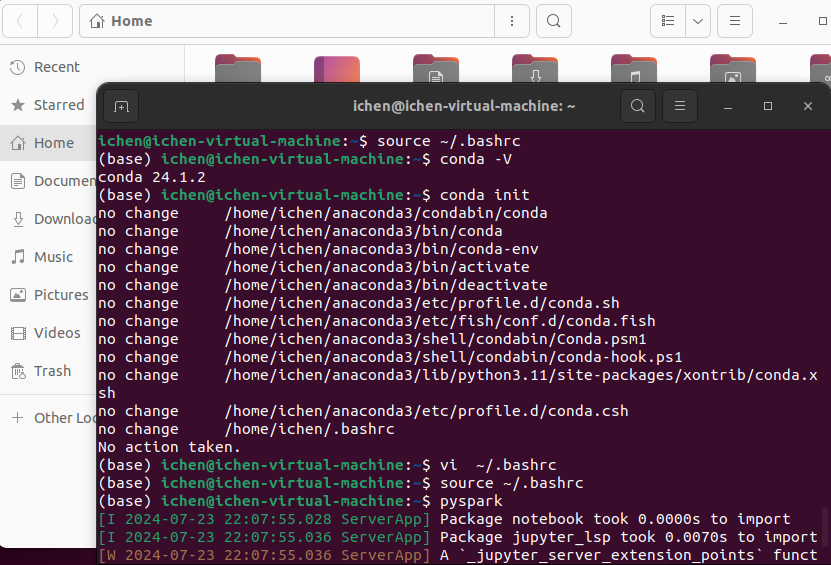

如果安装后输入conda -V查不到信息,显示conda: command not found,这是因为anaconda路径没有被识别,输入source ~/.bashrc。到此已经安装好Anaconda了。

之后配置环境变量,添加:

export PYSPARK_DRIVER_PYTHON="jupyter"

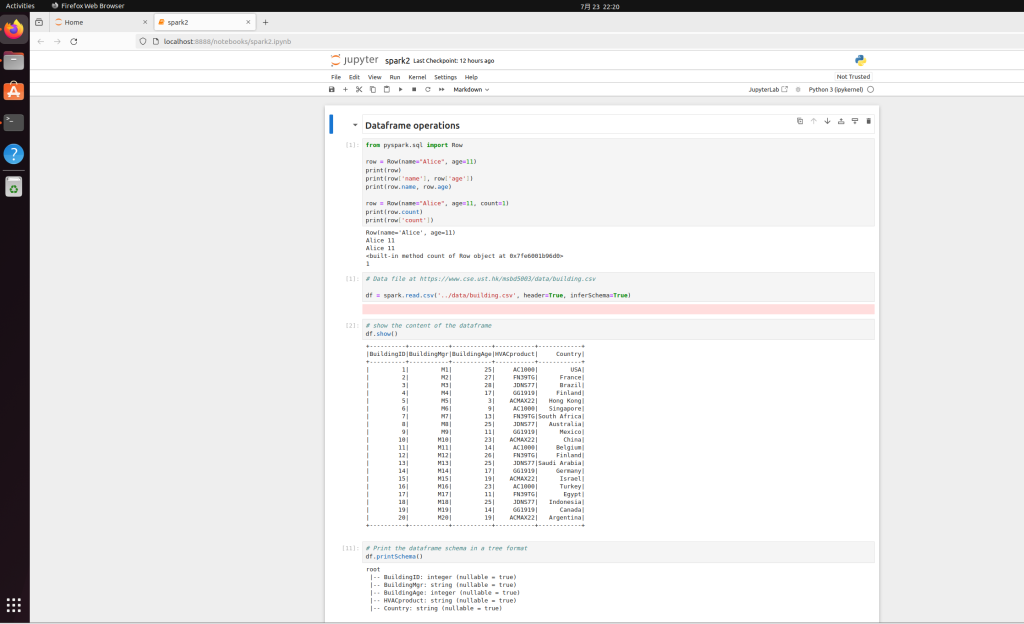

export PYSPARK_DRIVER_PYTHON_OPTS="notebook"source之后pyspark,如果想打开指定的网址上的.ipynb文件,需要先通过wget 网址来把文件下载到本地,再启动pyspark,在jupyter notebook界面打开文件来编辑。